Claus

Claus Marketingexperte bei JTL

Technische Aspekte zur Verbesserung der Performance von Onlineshops

Teil 3 der Blogserie: SEO für Onlineshops

Der Erfolg von SEO-Maßnahmen resultiert aus ganz unterschiedlichen Teilbereichen, deren Beachtung Euch ein stabiles Fundament legt, um im E-Commerce erfolgreich zu sein. In unserer vierteiligen Blogserie SEO für Onlineshops haben wir bereits die Themen Informationsarchitektur im Onlineshop und Content optimal aufbereiten ausführlich behandelt. In diesem dritten Teil konzentrieren wir uns auf wichtige technische Grundlagen Eures Onlineshops, die für eine gelingende Suchmaschinenoptimierung insgesamt unverzichtbar sind. Sie bilden die Voraussetzungen dafür, dass Euer Onlineshop und Eure Angebote überhaupt wahrgenommen werden und bestmöglich zugänglich sind und bleiben. Wir befassen uns mit Crawlbarkeit und Indexierung, den Seitenladezeiten und deren Optimierung sowie der Überwachung und Behebung technischer Fehler.

Crawlbarkeit und Indexierung

Die wohl wichtigste Voraussetzung für SEO ist, dass Suchmaschinen der nötige Zugriff zu all den Seiten gewährt wird, die in den Suchergebnissen erscheinen sollen. Denn ungesehen bringt auch erstklassiger Content keinen Traffic. Hier gibt es technische Hilfsdateien und Anweisungen, über die Ihr Zugriffsrechte für Crawler und die Indexierung von Seiten genauestens festlegen könnt.

Die robots.txt macht den Anfang

Die robots.txt-Datei ist eine der ersten Informationen, die von den Bots ausgelesen wird und damit ein entscheidendes Werkzeug zur Steuerung der Crawler von Suchmaschinen. In dieser Textdatei legt Ihr fest, welche Verzeichnisse, Unterverzeichnisse oder auch einzelnen Seiten oder Dateien von Google & Co. aufgesucht werden dürfen und welche Ihr sperren möchtet. Es steht Euch dabei frei, den verschiedenen Bots und User Agents unterschiedliche Anweisungen und Rechte zu geben.

Um sicherzustellen, dass Suchmaschinen die Datei robots.txt finden und berücksichtigen, müsst Ihr sie im Hauptverzeichnis Eurer Domain ablegen. Es ist wichtig zu verstehen, dass die robots.txt lediglich eine Hilfe und ein Wegweiser für Crawler ist. Durch das Sperren bestimmter Bereiche ist keinesfalls sichergestellt, dass Suchmaschinen diese Orte und Seiten nicht doch untersuchen, einlesen und ggf. auch indexieren. Zum Beispiel dann, wenn die Seite auf einer crawlbaren externen Seite verlinkt ist. Das „Disallow“ aus der robots.txt darf deshalb nicht verwechselt werden mit dem „noindex“-Tag für die Indexsteuerung (siehe weiter unten).

Beachtet bitte, dass die robots.txt keinen Schutz vor unbefugten Zugriffen bietet. Vielmehr gibt sie auch ungebetenen Gästen Hinweise darauf, wo sich ggf. verborgene oder kritische Bereiche befinden. Zur Sicherheit empfehlen wir die Verwendung eines Passwortschutzes auf Eurem Webserver.

Wie könnt Ihr die robots.txt konfigurieren?

Beim Umgang mit der robots.txt-Datei ist besondere Sorgfalt geboten! Kleine Fehler in der Syntax können ganze Seiten oder Verzeichnisse blockieren. Macht Euch also mit den Besonderheiten Eures Onlineshops und Sortiments und den individuell zu treffenden Einstellungen innerhalb der Datei vertraut und schließt beispielsweise die Seiten des administrativen Backends oder Seiten des Checkout-Prozesses aus. In den meisten Fällen bieten auch Filter- und Merkmalseiten Eures Shops keinen relevanten Mehrwert für die Crawler und erzielen auch im Index keine vorderen Plätze. Klare Anweisungen und der Ausschluss nicht relevanter Seiten und Bereiche spart also nicht nur Crawl-Budget, sondern fördert auch ein besseres Verständnis bei Google und anderen Suchmaschinen durch die Fokussierung auf wichtige Inhalte.

Das Crawl-Budget bezeichnet übrigens die Anzahl der Seiten, die Google maximal in Eurem Onlineshop durchsucht. Es wird von Google festgelegt und hängt von Eurem Ranking ab. Seiten mit einem höheren Ranking erhalten ein größeres Crawl-Budget, das bestimmt, wie oft wichtige Seiten durchsucht werden und wie tief das Crawling erfolgt.

Die Verwendung von (Robots-)Meta-Tags

Wie zuvor schon angerissen, erfüllen Meta-Tags wichtige Funktionen, um Suchmaschinen zusätzliche Informationen über die aktuelle Seite mitzuteilen. So könnt Ihr beispielsweise mit dem Robots-Meta-Tag und der Regel <meta name=“robots“ content=“noindex“>, die im <head>-Abschnitt der Seite platziert wird, Suchmaschinen anweisen, die Seite nicht in ihren Index aufzunehmen.

Bei Verwendung von „Noindex“ darf dieselbe Seite nicht gleichzeitig über ein „Disallow“ in der robots.txt ausgeschlossen werden. Der Crawler hätte sonst keinen Zugriff, könnte den <noindex>-Tag nicht auslesen und die Seite würde möglicherweise ungewollt im Index verbleiben.

In der äußerst hilfreichen Dokumentation von Google kannst Du mehr über die Spezifikationen für Robots-Meta-Tags erfahren. Auch die anderen Abschnitte des Kapitels „Crawling und Indexierung“ sind lesenswert und versetzen Euch in die Lage, die richtigen Einstellungen für Euren Onlineshop zu finden.

XML-Sitemaps unterstützen die Suchmaschine

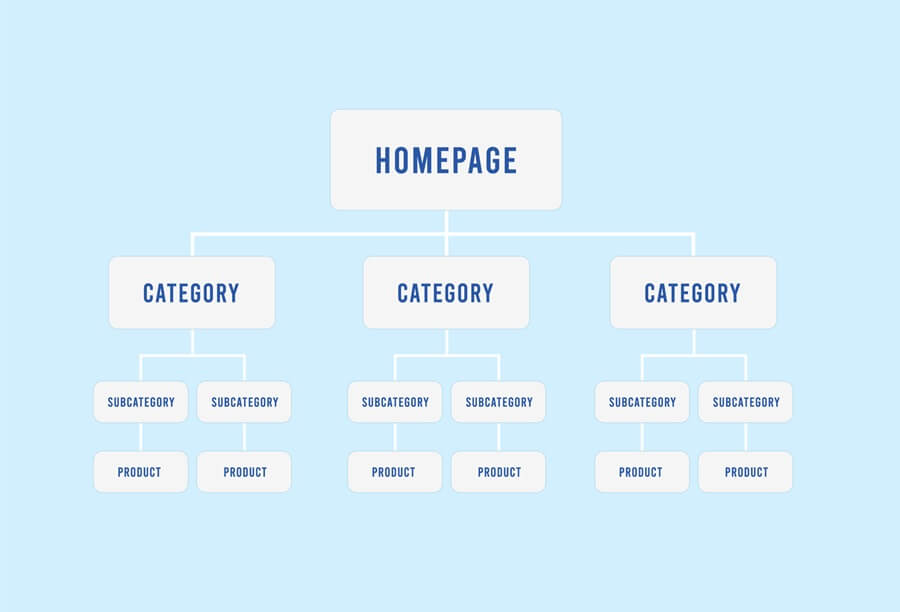

Die XML-Sitemap erleichtert es den Suchmaschinen, eine umfassende Liste aller Seiten Eures Onlineshops zu erhalten – insbesondere auch von solchen Seiten, die schwer zugänglich sind oder keine internen Links aufweisen. Gerade bei neuen (noch wenige externe Links) oder großen Onlineshops mit möglicherweise tieferen Verzeichnisstrukturen solltet Ihr auf den Einsatz von einer oder auch mehrerer Sitemaps (für Videos, Bilder etc.) nicht verzichten. Sie können den Suchmaschinen zudem wichtige Angaben zur letzten Aktualisierung oder auch zu alternativen Sprachversionen der Seite liefern.

Die Struktur Eurer XML-Sitemap sollte logisch aufgebaut sein und die Hierarchie Eures Onlineshops widerspiegeln. Stellt sicher, dass die wichtigsten Seiten am Anfang stehen und dass keine redundanten oder doppelten Seiten enthalten sind. Fertig eingerichtet – und so schließt sich der Kreis – sollte die XML-Sitemap auch in der robots.txt-Datei referenziert werden.

Seitenladezeit und Geschwindigkeitsoptimierung

Die Ladezeit einer Webseite wird auch als Pagespeed bezeichnet. Es erklärt sich von selbst, dass kurze Ladezeiten Eure Shopbesucher glücklich machen, während ein langsamer und verzögerter Seitenaufbau schnell zum Kaufabbruch führen kann und die Conversion Rate schrumpfen lässt. Auch die Suchmaschinen haben das längst erkannt und Google hat Pagespeed als maßgeblichen Rankingfaktor schon vor Jahren bestätigt. Wachsende Zugriffszahlen über mobile Geräten erhöhen zusätzlich den Druck, die Geduld der Nutzer nicht zu strapazieren. Doch welche technischen Faktoren verbergen sich hinter langen Ladezeiten und was kann man dagegen tun?

Dateigröße von Bildern, Videos und Code optimieren

Eine große Rolle für die Ladegeschwindigkeit spielt die Gesamtdatenmenge, die ein Server zum Laden der Shopseite bereitstellen muss. Hier fallen Inhalte wie Bilder oder Videos am stärksten ins Gewicht. Haben beispielsweise Artikelbilder eine Größe von über 1 MB, kann die Größe einer Seite bei mehreren Bildern, die gleichzeitig abgerufen werden, sehr schnell in die Höhe schießen und den Seitenaufbau enorm verzögern. Bilder und Videos sollten deshalb nie in einer höheren Auflösung hochgeladen werden, als jeweils benötigt wird. Für die mobile Variante einer Seite sollte daher immer eine eigene Mobil-Version der jeweiligen Datei bereitgestellt werden. Zudem stehen viele weitere Tools oder Plugins zur Verfügung, die die Datenmenge von Bildern, CSS, HTML oder JavaScript nochmals komprimieren und so Eure Performance verbessern.

Daten über ein Content Delivery Network bereitstellen

Bei einem Content Delivery Network (CDN) handelt es sich um ein Netzwerk aus Servern an unterschiedlichen Standorten, die angefragte Daten durch geografische Nähe schnellstmöglich an die Nutzer ausspielen. Dafür werden die Daten vom Ursprungs-Hoster auf andere Server gespiegelt und der Server mit der geringsten Entfernung ruft diese für den Nutzer ab, was die Ladezeit nochmals verkürzt. Diese Form der Datenbereitstellung kommt in der Regel beim Streaming zum Einsatz, wird aber auch von anderen Seiten mit großer Reichweite genutzt, um die Lastverteilung und Performance zu optimieren.

Wie könnt Ihr Pagespeed und Performance überprüfen?

Zur Prüfung der Ladezeiten stehen Euch zahlreiche Onlinetools zur Verfügung. Auch Google stellt mit der Browsererweiterung Lighthouse und den PageSpeed Insights eigene Werkzeuge bereit, um die Geschwindigkeit und das Verhalten von Seiten zu prüfen und zu optimieren. Analysiert wird hier anhand unterschiedlicher Metriken, wie zum Beispiel dem „Largest Contentful Paint“ (wie lange das Laden bzw. Rendern des größten Bild- oder Textblocks dauert). Schaut Euch hier gerne auch die weiteren Messwerte genauer an und profitiert von den detaillierten Angaben und Verbesserungsvorschlägen im Diagnosebereich des Tools.

Zusammengefasst werden solche Indikatoren als Core Web Vitals bezeichnet. Google hat diese 2021 mit dem Ziel der Bewertung und Verbesserung der User Experience von Webseiten definiert. Für Euren Onlineshop könnt ihr die vorrangig performance-orientierten Metriken und die empfohlenen Richtwerte als Checkliste für schnelle Ladezeiten und allgemein gute Usability verstehen.

Technische Prüfung und Fehlerbehebung

Zu den zentralen Maßnahmen der technischen Suchmaschinenoptimierung zählen die regelmäßige Überprüfung und das Monitoring Eurer Seiten. Für das Überwachen wichtiger Performancewerte, das Nachjustieren sensibler Stellschrauben und eine unter Umständen zügige Fehlerbehebung solltet Ihr ausreichend Zeit und Ressourcen kalkulieren. Durch die zahlreichen Teilaspekte, die Technical SEO mit sich bringt, vor allem aber auch durch die häufigen (Core-)Updates die von Google & Co. ausgerollt werden, ergeben sich immer wieder neue Rahmenbedingungen, die eine Reaktion Eurerseits erforderlich oder mindestens empfehlenswert machen. Ein äußerst hilfreiches Tool zur technischen Überwachung und Analyse ist die Google Search Console.

Wie könnt Ihr die Google Search Console nutzen?

Die Google Search Console (GSC) ist ein kostenloser Dienst von Google, der es Website- und Shopbetreibern ermöglicht, ihre Präsenz in den Google-Suchergebnissen zu überwachen, zu verwalten und Ansätze zu finden, die Performance zu verbessern oder Fehler zu beheben. Ihr erhaltet über die GSC wertvolle Einblicke, wie Google Euren Onlineshop sieht und bewertet, und könnt Informationen zur (technischen) Gesundheit, zur Usability und zur Suchmaschinenfreundlichkeit erhalten.

Zu den wichtigsten Funktionen der GSC im Bereich Crawling und Indexierung zählen die Einblicke in den Indexierungsbericht und den Bericht der Crawling-Statistiken. Hier könnt Ihr nicht nur das Verhältnis und den Gesamtstatus Eurer indexierten und nicht-indexierten Seiten einsehen, der Bericht gibt Euch auch detailliert Auskunft, warum Seiten nicht indexiert sind. Damit ist dieser Bericht ein häufiger Ausgangspunkt, um beispielsweise Umleitungsfehlern oder falsch gesetzten Canonical-Tags auf die Spur zu kommen.

Die Crawling-Statistiken (der Bericht ist etwas versteckt unter den Einstellungen der GSC zu finden) wiederum zeigen Euch, wie häufig und mit welchem Ergebnis die unterschiedlichen Googlebots mit Eurem Onlineshop bzw. dem Server interagieren. So lassen sich beispielsweise sämtliche Crawling-Anfragen nach den Antwortcodes des Servers aufschlüsseln, um hier 404-Seiten, 5xx-Serverfehler oder das Ausmaß der 3xx-Weiterleitungen zu identifizieren.

Es gibt zahlreiche weitere Analysefunktionen und empfehlenswerte Strategien, um die Google Search Console effektiv für Euren Onlineshop einzusetzen. Wir ermutigen Euch daher, Euch eingehender mit diesem Thema zu befassen, alle verfügbaren Optionen zu erkunden und in regelmäßigen Abständen nachzuschauen, was Euch das Tool zu sagen hat. Auch hierzu steht Euch online eine Fülle an hochwertigen Videos oder Webinaren zur Verfügung, nicht zuletzt die Dokumentation von Google selbst: https://search.google.com/search-console/about

Eine solide Grundlage für weitere SEO-Maßnahmen

Es gilt viele technische Aspekte zu berücksichtigen, um Euren Onlineshop gut und besser für Suchmaschinen aufzustellen. Indem Ihr unsere Tipps und Ratschläge befolgt oder auch die wichtigsten Erkenntnisse von Tools wie der Google Search Console beherzigt, schafft Ihr bereits sehr gute Voraussetzungen, um eine bessere organische Sichtbarkeit zu erreichen. Im Idealfall werden Eure technischen Verbesserungen begleitet von anderen wichtigen Maßnahmen im Rahmen einer ganzheitlichen übergeordneten SEO-Strategie.

Falls Ihr also die vorherigen Artikel aus unserer vierteiligen Serie zur Suchmaschinenoptimierung noch nicht gelesen habt, empfehlen wir dringend, dies nachzuholen. Der vierte und letzte Teil beschäftigt sich mit KI-Tools im E-Commerce und deren Bedeutung für die Suchmaschinenoptimierung.

Alle Beiträge der SEO-Blogserie im Überblick:

Teil 1: Informationsarchitektur im Onlineshop

Teil 2: Content – Inhalte optimal aufbereiten

Teil 3: Technical SEO zur Verbesserung der Performance

Teil 4: Künstliche Intelligenz: Anwendungsbereiche SEO

Erhalten Sie wichtige Infos zu unseren Produkten sofort.

Social Media